- MyDefrag v4.2.6

Nueva versión de este conocido programa de defragmentación de nuestro disco duro.  Nokia PC Suite 7.1.40.1

Nokia PC Suite 7.1.40.1

Última versión de la suite de Nokia para conectar teléfonos móviles y realizar copias de seguridad del mismo.- FileZilla Client 3.3.0.1

Pequeña revisión de la recién estrenada versión 3.3x del cliente de FTP gratuito y multiplataforma de FileZilla. - JDownloader 0.9.579

Un gestor de descargas gratuito y que utiliza JAVA que sirve para simplificar la descarga de archivos de servidores como Rapidshare o Megaupload.  Google Chrome 4.0.245.0 Beta

Google Chrome 4.0.245.0 Beta

Enésima versión de este ya conocido navegador de Internet.- WinRAR 3.91 beta 1

Parece que los chicos de RARlab se vuelven a poner a la carga y ya está de camino la versión 3.91 de su conocido compresor de ficheros, de momento en estado beta. - Google Chrome 4.0.249.0 Beta

Enésima versión beta de la serie 4 del navegador de Google y es que parece que esto se va a convertir en la tónica habitual. - iMON/iMEDIAN HD Version 7.77.1022

Hace muchos días de eso, pero un servidor que lo utiliza a diario no se había dado cuenta hasta hoy de una nueva actualización de este conocido software para HTPC. Es la primera versión oficial para Windows 7.  Firefox 3.6 Beta 3

Firefox 3.6 Beta 3

Firefox 3.6 sigue calentando motores.- Zoom Player 7.00

Nueva y renovada versión de este reproductor multimedia que tiene una buena reputación. - Spyware Terminator 2.6.4.165

Uno de los programas anti Spyware que más éxito tiene en los últimos tiempos. - Comodo Internet Security 3.13.119746

Un firewall por software en versión Freeware para nuestro equipo. - S.T.A.L.K.E.R.: Call of Pripyat Benchmark

Un benchmark que puede resultar interesante para probar tarjetas gráficas de última generación. - FRAPS 3.0.2

Varias correcciones para este útil programa que tras la llegada de Windows 7 ha sufrido varias actualizaciones. - GPU-Z v0.3.7

Era fácil de suponer que tras el lanzamiento de varias tarjetas gráficas como la HD 5970 y la GT 240 saliese una nueva versión de GPU-Z la cual trae más correcciones y novedades. Así como mostrar más información y si nuestra GPU soporta CUDA, PhysX, OpenCL o DirectX Compute.  PowerArchiver 11.61

PowerArchiver 11.61

Una nueva versión de otro de los programas de compresión de ficheros bastante utilizado.- ATI Tray Tools 1.6.9.1435

Actualización de esta alternativa al panel de control de ATi. - QuickTime Alternative 3.1.0

Una versión recortada del visualizar de ficheros de Apple.  Realtek High Definition Audio Drivers v2.37

Realtek High Definition Audio Drivers v2.37

Revisión de los controladores de Realtek para los chips de sonido integrados.

viernes, 4 de diciembre de 2009

Links

DiamonDisc: DVD con 1.000 años de longevidad

Un DVD tradicional tiene una vida media de 2 a 5 años, sin embargo una nueva compañía, Cranberry LLC, ha presentado un nuevo sistema de discos -DiamonDisc- que son capaces de aguantar hasta 1.000 años y temperaturas de hasta 80ºC, entre otros.

El disco en cuestión es un DVD tradicional pero fabricado con un sustrato para datos mucho más resistente y transparente, para grabarlos hace falta una unidad especial ya que la longitud de onda y potencia de las grabadoras convencionales no tienen efecto sobre los discos, al grabar, ya que pueden reproducirlos/leerlos sin problema alguno.

La tecnología es muy interesante de cara al futuro y a almacenar nuestros datos, sin embargo, la grabadora cuesta 4.995 dólares. Además, el DiamonDisc tiene un precio unitario de 34,95 dólares, y si compras dos o más cada uno te sale a 29,95 dólares.

CoD 6 recibió su primera actualización y primeros cheats

Según podemos leer en la web de noticias de Steam, el pasado viernes y vía STEAM, se actualizó Call of Duty: Modern Warfare 2 con un pequeño parche que únicamente mejora el sistema de emparejamiento entre jugadores en el modo multijugador. "Improved IWNet matchmaking".

Sin embargo hay una noticia negativa, y es que Infinity Ward quería mejorar el sistema de de protección contra las trampas, para ello decidieron utilizar el Valve's VAC, conexión a Steam y el hecho de que no existan servidores dedicados. A pesar de estas medidas parece que ya se han visto los primeros "chetos" corriendo por Internet e incluso se publicó un vídeo en Youtube mostrando a usuarios utilizando wallhacks (los que permiten ver a través de las paredes).

El hecho de que se viesen los primeros wallhacks 48h después de la salida del juego fue un mal presagio para muchos usuarios. IW para mejorar su imagen ha solicitado borrar el vídeo de Youtube alegando violación de copyright y ya no lo podemos ver... Sin embargo de momento no han anunciado solución para este cheat.

Google tiene intenciones de destronar a Microsoft Office

Dave Girouard es el presidente de la división empresarial de Google y ha asegurado que la mayoría de empresas tendrán la oportunidad de deshacerse de Microsoft Office el año que viene, que será cuando Google Docs reciba 50 mejoras y actualizaciones que hagan de la misma un servicio sustitutivo de la suite ofimática de Microsoft.

Girouard es uno de los cuatro presidentes de Google, ha demostrado la capacidad de potenciar su suite de productividad y colaboración Docs/Apps en el segmento corporativo y ha prometido ponerse a la altura de Office en cuestión de un año:

"Docs alcanzará una capacidad el próximo año que permitirá a la mayoría de empresas deshacerse de Office si así lo desean".

Rendimiento de la plataforma LGA1156 con memoria DDR3

En la web de iXBT Labs publican un interesante artículo dedicado al funcionamiento y rendimiento de la plataforma LGA 1156 con memoria DDR3 al que vale la pena echarle una ojeada.

Lo primero que nos recuerdan es que ahora ya no quedan sistemas modernos con controlador de la memoria en el Northbridge, el último caso es el actual Core 2, pero que ya no es "lo más moderno". Así pues, el rendimiento del sistema de memoria ya no depende del chipset, cosa que permite una comunicación más rápida y que una mala implementación por parte del fabricante lastre su rendimiento. Evidentemente del chipset aún depende el rendimiento de otros dispositivos, como el sistema de almacenamiento o el sistema de E/S.

A su vez, el hecho que la controladora de memoria esté integrada en el procesador impide aislar este factor y por lo tanto analizar un procesador se convierte en algo más complejo. Por ejemplo, ahora el controlador de memoria está en la CPU y esto provoca más calor y problemas de microparones para evitar que supere cierto límite de temperatura. Así que hay más variables dentro de un mismo componente.

Citan que ahora que hay menos intermediarios entre el procesador y la memoria, las latencias ganan importancia. Reconocen que esto no es nuevo ya que AMD lleva haciendo esto desde hace años, pero ahora que se ha trasladado a Intel la cuota de usuarios aumenta mucho, de hecho pronto no habrá equipo nuevo que no tenga este tipo de controladora de memoria.

La plataforma LGA 1156 puede soportar como máximo 16GB mientras que la LGA1366 puede alcanzar 24GB, dicha limitación no parece muy preocupante a día de hoy, por lo menos en equipos para el hogar, incluidos los videojuegos. Nos explican que podemos encontrar placa con 6 bancos de memoria en ambos sistemas, sin embargo la plataforma LGA 1366 hace uso del triple canal de memoria y esta cantidad es la ideal para sus sistemas, mientras que la LGA 1156 utiliza doble canal de memoria y por lo tanto lo ideal es poner módulos por parejas y no trios. Así la plataforma LGA 1366 soporta hasta 4 GB por módulo. En cambio la plataforma LGA 1156 sólo soporta 3 módulos por canal de memoria y como máximo se pueden ocupar 8 canales (hay módulos de memoria de un canal y de dos, creemos que es básicamente lo mismo que hablar de un módulo de una cara o de doble cara). Así pues utilizando módulos de doble cara como máximo podemos ocupar 4 slots de memoria.

También nos explican la complejidad del sistema de memoria del socket LGA 1366 y que en este aspecto podemos salir ganando con el LGA1156, ya que una controladora más simple permite que todo funcione bien a mayor velocidad, aunque una cosa es la lógica y la otra será la práctica. Ya a modo aún más complejo nos explican que el socket LGA 1366 soporta hasta 18 bancos de memoria y no 12 como cabría esperar, sin embargo esto lo hace con ciertas limitaciones como es la de velocidad DDR3-800

Ahí cabe recordar que oficialmente los procesadores Core i7-900 con núcleo Bloomfield soportan memoria DDR3-1067, no superior, el resto se considera overclock. Con los Core iX Lynnfield el soporte para DDR3 ha subido oficialmente a DDR3-1333 y para los AMD Phenom II AM3 también estamos con DDR3-1333.

Realizan dos baterías de pruebas, una corta para comprobar algunos datos sobre el rendimiento de la memoria y una más larga para probar todos los tests. Realizan comparaciones con un Core i7-920 LGA 1366, un Core i5-750 e incluso un Phenom II AM3.

Todas las pruebas se centran en el Core i7-860 Lynnfield LGA 1156 el cual funciona a 2,8 GHz. Nos hablan de la velocidad de núcleo del Core i7-860 marcada como 2,8 GHz, sin embargo este procesador tiene una velocidad UnCore de 2,4 GHz, así que deciden realizar pruebas con otros procesadores como el Core i7-920 y Core i5-750 que tienen una velocidad UnCore de 2,13 GHz, este parámetro tiene relevancia en el rendimiento final.

Bien, ¿qué es la velocidad UnCore?

pues es la velocidad del controlador de memoria de los Core iX y que también controla la velocidad de la caché L3 de los procesadores, el controlador de memoria funciona a una velocidad distinta a la del procesador. Por ejemplo un Core i7-920 tiene una velocidad de base o BCLK de 133 MHz, un multiplicador de núcleo de x20 y un multiplicador de UnCore de x16. En cambio el i7-950 tiene un multiplicador de x23 pero sigue con el de x16 en la velocidad del controlador de memoria. El Core i7-965 y 975 ya disponen de un multiplicador de x20 en la velocidad UnCore.

Así las velocidades habituales de los Core i7 son de 2,13 GHz y de 2,66 GHZ en el apartado de UnCore, dependiendo del modelo. Los procesadores LGA 1156 tienen una velocidad UnCore distinta si hablamos de Core i5, 2,13 GHz o si lo hacemos de los Core i7-800 la velocidad sube a 2,4 GHz, ya que el multiplicador es de x18 en este último caso.

Primeras pruebas: Para las pruebas escogen un Core i7-860 a 2,8 GHz socket LGA 1156 y realizan comparaciones con un Core i7 LGA 1366 e incluso Core i5-750. Las configuraciones son la siguientes: En las pruebas de rendimiento de lectura con Everest detectan como la velocidad de los módulos afecta directamente a su rendimiento, pero incluso a la misma velocidad el Core i7-860 con 8GB es el más rápido gracias a su velocidad y a que está ocupando todos los bancos de memoria. Seguidamente realizan pruebas de escritura en la memoria y detectan que quien marca la velocidad real de escritura es justamente la velocidad UnCore de los procesadores y no la velocidad de la propia memoria, puesto que el mismo procesador obtiene resultados idénticos independientemente de si utiliza DDR3-1066 o DDR3-1333, siendo aquí el Core i7-860 el ganador, tanto si ocupa todos los bancos de memoria como si sólo ocupa la mitad y como hemos dicho de forma independiente a se frecuencia. Concluyen que para aumentar la velocidad de la memoria habría que aumentar la velocidad del apartado UnCore, sin embargo ésta está bloqueada en la plataforma LGA 1156 y la única forma de aumentarla es incrementando la velocidad de base, FSB o BCLK. Siguen realizando pruebas y llegan a las latencias de la caché y memoria; ahí se obtiene mejor rendimiento cuando mayor es la frecuencia de la memoria, del apartado UnCore y cuántos menos módulos utilizamos. Incluso con una plataforma LGA 1366 la latencia es mayor (peor) con triple canal de memoria que con doble canal. Después de estas pruebas concluyen que la plataforma LGA 1156 aprovecha mejor la memoria DDR3 que la LGA 1366 teniendo más sentido ir a por conseguir DDR3-1333 en vez de 1066, aunque las diferencias tampoco son muy elevadas. Con estos datos preliminares descartan un par de modos y se ponen a realizar la batería completa de pruebas con otros procesadores. Para el resto del artículo ya utilizan otros tests y ponen a prueba el Phenom II X4 965 en dos modalidades de 4 GB (7-7-7-20) y 6GB (8-8-8-24) todas ellas a DDR3-1333 El segundo caso ocupa 4 bancos y el primer caso 2 bancos. Quitan el Core i5-750 de las pruebas y mantienen el Core i7-920. El objetivo no es tanto comparar los distintos procesadores sino ver como se mueven bajo las distintas configuraciones de memoria, evidentemente recomendamos su lectura detenida pero ahí tenemos un intento de resumen: 3D visualization 3D rendering Scientific and engineering analysis Bitmap processing Data compression Compiling Java Audio encoding Video encoding 3D games Cuando llegan a las conclusiones dicen que esperaban más del soporte para DDR3-1333, sin embargo se puede tomar como una buena noticia desde el punto de vista de aprovechar memoria antigua DDR3-1066 ya que no ofrecen un rendimiento notablemente inferior. Así invertir en memoria de alta velocidad cuesta de justificar, ya pasar de DDR3-1066 a 1333 tiene poco sentido, excepto algunos casos contados, así que velocidades más elevadas como DDR3-1600 aún cuestan más de justificar. Evidentemente esto es así si no es que vamos a realizar overclock del procesador y del controlador de memoria, ya que al incrementar dichas velocidades podemos quedarnos cortos en los divisores disponibles y necesitar memorias más rápidas, ahí veremos incrementos notables de rendimiento, aunque este no es el tema de estudio de este análisis.

3ds max, Maya, Lightwave, SolidWorks, Pro/ENGINEER y UGS NX -> Con programas de visualización 3D, como 3DStudio, Maya, etc... la cantidad de memoria gana y la mejor combinación es la del Core i7-860 con 8GB (todos los bancos ocupados), aunque las diferencias son muy pequeñas. Los Phenom II quedan por debajo de cualquier combinación de Core i7-800 pero por encima de los Core i7-900.

3ds max, Maya y Lightwave -> Las pruebas de renderizado 3D dependen poco de la latencia y de la cantidad de memoria, aquí quien sale peor es el Phenom II y quien gana vuelve a ser el Core i7-800.

MAPLE, Mathematica, MATLAB, SolidWorks, Pro/ENGINEER y UGS NX -> Igual que en el primer caso, primero Core i7-800, luego Phenom II y finalmente Core i7-900.

ACDSee, Paint.NET, PaintShop Pro, PhotoImpact y Photoshop -> Dentro de este grupo Photoshop sale de la media y fuerza buenos resultados con grandes cantidades de RAM, en concreto con 6GB. En general primero queda el Core i7-800, luego Core i7-900 y finalmente Phenom II. Parece que el ancho de banda no importa demasiado, incluso con triple canal se pierde rendimiento respecto doble canal bajo un Core i7-920.

7-Zip y WinRAR -> Lo que importa es la velocidad del controlador, de las memorias y la latencia de las mismas, ganamos al dejar un Core i7-900 con doble canal y al dejar menos módulos de memoria para mejorar dichas latencias. Gana Core i7-800, Core i7-900 y Phenom II.

Microsoft Visual Studio 2008 -> con resultados a favor de Core i7-800, Core i7-900 y finalmente Phenom II. La velocidad de la memoria parece afectar algo, así como la velocidad del controlador.

SPECjvm2008 -> Aquí estamos ante uno de los pocos tests que mejoran de doble a triple canal de memoria, hay pocas diferencias.

dBpoweramp -> Sólo importa la velocidad del procesador, no la del sistema de memoria, cantidad o latencias.

Canopus ProCoder, DivX, Mainconcept, x264, XviD -> El triple canal de memoria vuelve a dar un pequeño empujoncito, el Core i7-800 gana en todos los casos e incluso la velocidad de la memoria no parece importar mucho.

STALKER: Clear Sky, Devil May Cry 4, Far Cry 2, Grand Theft Auto 4, Lost Planet, Unreal Tournament 3, Crysis: Warhead, World in Conflict -> Muy pocas variaciones con los juegos, quizá el elemento más importante es la velocidad de la memoria dentro de la misma plataforma.

Google quiere enterrar al protocolo HTTP por su SPDY

Google ha anunciado que va a comenzar a hacer una transición desde el vetusto protocolo HTTP hacia el novedoso SPDY (speedy en inglés). Con ello pretenden disminuir la latencia y tiempos de espera a la mitad y ello hace que las transmisiones de datos sean un 64% más rápidas.

La implementación de SPDY tiene que hacerse en los servidores y en los navegadores, es decir no tendrá que modificarse web alguna. Google está preparando un servidor web y ya está desarrollando la versión de Chrome con SPDY activo.

SPDY es una implementación del protocolo HTTP en el que se ha dejado de lado la parte de gestión de transferencias de datos y se ha integrado un sistema de peticiones multiplexadas, las peticiones con prioridad y cabeceras comprimidas.

Stalker: Call of Pripyat - DirectX 11 vs. DirectX 10

S.T.A.L.K.E.R. nunca ha sido una saga que se caracterice por sus bajos requisitos técnicos y siempre se ha pedido mucha máquina para poderlo mover decentemente. Sin embargo la experiencia visual del juego es muy rica y pocos títulos pueden competir con, por ejemplo, la iluminación de los escenarios creados con el motor X-Ray. En este caso la versión 1.6.

La tercera entrega de STALKER ya corre en Rusia y Alemania y hoy tenemos nuevos detalles, En PC Games Hardware publican una corta pero reveladora comparativa de rendimiento entre activar o no los niveles máximos de detalle: Teselación ON/OFF gracias a utilizar hardware DirectX 11.

Pocas imágenes comparativas hay, pero en ellas podemos apreciar una cierta mejora gráfica dada por un mayor volumen de los objetos, aunque en algunas partes parece un tanto exagerada aparatos electrónicos en el cinturón o en los pantalones, en cambio en otros, como el filtro de aire del traje se aprecia la mejora visual notable (recomendamos visitar la web con imágenes a mayor resolución y calidad).

Sin embargo parece que el precio a pagar por ello también es muy elevado y jugar al máximo a este juego va a ser cosa de algunos privilegiados que dispongan de algo más potente que una Radeon HD 5870.

Para las pruebas utilizan su Core i7 @ 3,5 GHz con 6 GB de RAM y Windows Vista SP2. Prueban el juego a 1680x1050 en dos modos, AF 16x FSAA 0x y AF16x MSAA 4x. Con filtros al máximo y todo activado parece que nos podemos olvidar de la suavidad deseada con 27,8 FPS de media. Sin FSAA la media ya resulta algo más decente: 42,2 FPS.

Para cada situación hacen tres pasadas, una con DirectX 10.1 teselación off, otra con DirectX 11 teselación off y otra con DirectX 11 teselación on.

La mala noticia es que de activar a desactivar la teselación tenemos una pérdida alrededor del 30-45% (dependiendo de los filtros) y los FPS mínimos aún caen mucho más, incluso por debajo de la mitad en algunos casos. La buena noticia es que lo mismo utilizando DX 10.1 y DX 11 demuestra que la última iteración de la API ofrece ciertas mejoras de rendimiento, alrededor del 19%, cosa que parece transmitirnos que DirectX 11, ni que sea viendo lo mismo, nos puede ofrecer mejoras al permitir un aumento de rendimiento respecto al poco utilizado DirectX 10 y 10.1, pero por lo visto o pulen mucho los drivers y el motor o esta ganancia de rendimiento no evita que la teselación se coma todo lo ganado y bastante más.

Tampoco se pueden sacar conclusiones con un único juego y más siendo el primero que vemos. Sin embargo el test de Unigine Heaven ya demostró que la Teselación no era precisamente gratuita, así que los programadores deberán ser prudentes para no abusar de esta nueva y llamativa función, la cual de nueva tampoco tiene mucho, por lo menos a nivel de software.

lunes, 16 de noviembre de 2009

The History of the Internet in a Nutshell

If you’re reading this article, it’s likely that you spend a fair amount of time online. However, considering how much of an influence the Internet has in our daily lives, how many of us actually know the story of how it got its start?

Here’s a brief history of the Internet, including important dates, people, projects, sites, and other information that should give you at least a partial picture of what this thing we call the Internet really is, and where it came from.

While the complete history of the Internet could easily fill a few books, this article should familiarize you with key milestones and events related to the growth and evolution of the Internet between 1969 to 2009.

1969: Arpanet

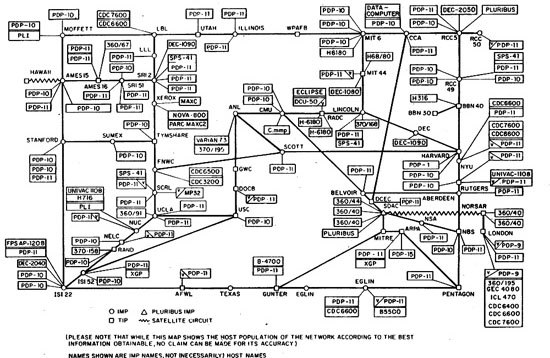

Arpanet was the first real network to run on packet switching technology (new at the time). On the October 29, 1969, computers at Stanford and UCLA connected for the first time. In effect, they were the first hosts on what would one day become the Internet.

The first message sent across the network was supposed to be "Login", but reportedly, the link between the two colleges crashed on the letter "g".

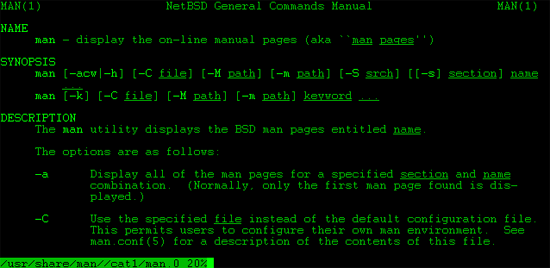

1969: Unix

Another major milestone during the 60’s was the inception of Unix: the operating system whose design heavily influenced that of Linux and FreeBSD (the operating systems most popular in today’s web servers/web hosting services).

1970: Arpanet network

An Arpanet network was established between Harvard, MIT, and BBN (the company that created the "interface message processor" computers used to connect to the network) in 1970.

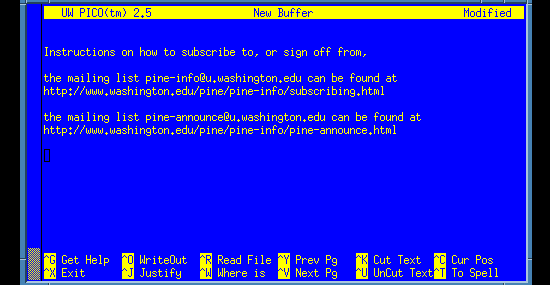

1971: Email

Email was first developed in 1971 by Ray Tomlinson, who also made the decision to use the "@" symbol to separate the user name from the computer name (which later on became the domain name).

1971: Project Gutenberg and eBooks

One of the most impressive developments of 1971 was the start of Project Gutenberg. Project Gutenberg, for those unfamiliar with the site, is a global effort to make books and documents in the public domain available electronically–for free–in a variety of eBook and electronic formats.

It began when Michael Hart gained access to a large block of computing time and came to the realization that the future of computers wasn’t in computing itself, but in the storage, retrieval and searching of information that, at the time, was only contained in libraries. He manually typed (no OCR at the time) the "Declaration of Independence" and launched Project Gutenberg to make information contained in books widely available in electronic form. In effect, this was the birth of the eBook.

1972: CYCLADES

France began its own Arpanet-like project in 1972, called CYCLADES. While Cyclades was eventually shut down, it did pioneer a key idea: the host computer should be responsible for data transmission rather than the network itself.

1973: The first trans-Atlantic connection and the popularity of emailing

Arpanet made its first trans-Atlantic connection in 1973, with the University College of London. During the same year, email accounted for 75% of all Arpanet network activity.

1974: The beginning of TCP/IP

1974 was a breakthrough year. A proposal was published to link Arpa-like networks together into a so-called "inter-network", which would have no central control and would work around a transmission control protocol (which eventually became TCP/IP).

1975: The email client

With the popularity of emailing, the first modern email program was developed by John Vittal, a programmer at the University of Southern California in 1975. The biggest technological advance this program (called MSG) made was the addition of "Reply" and "Forward" functionality.

1977: The PC modem

1977 was a big year for the development of the Internet as we know it today. It’s the year the first PC modem, developed by Dennis Hayes and Dale Heatherington, was introduced and initially sold to computer hobbyists.

1978: The Bulletin Board System (BBS)

The first bulletin board system (BBS) was developed during a blizzard in Chicago in 1978.

1978: Spam is born

1978 is also the year that brought the first unsolicited commercial email message (later known as spam), sent out to 600 California Arpanet users by Gary Thuerk.

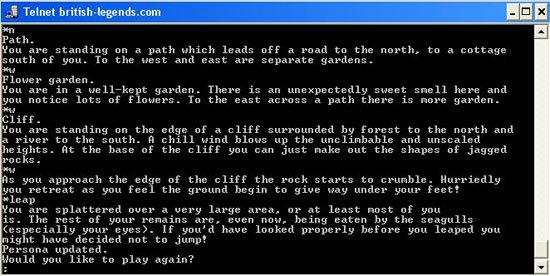

1979: MUD – The earliest form of multiplayer games

The precursor to World of Warcraft and Second Life was developed in 1979, and was called MUD (short for MultiUser Dungeon). MUDs were entirely text-based virtual worlds, combining elements of role-playing games, interactive, fiction, and online chat.

1979: Usenet

1979 also ushered into the scene: Usenet, created by two graduate students. Usenet was an internet-based discussion system, allowing people from around the globe to converse about the same topics by posting public messages categorized by newsgroups.

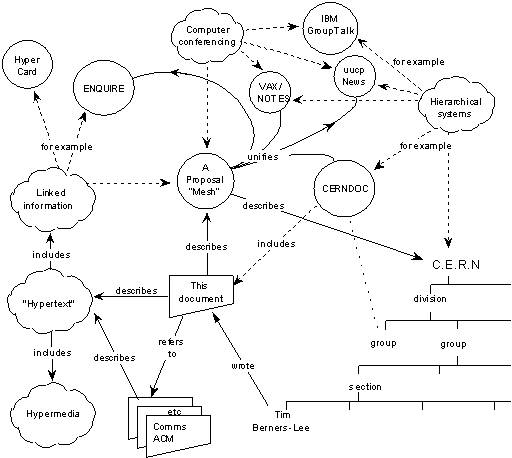

1980: ENQUIRE software

The European Organization for Nuclear Research (better known as CERN) launched ENQUIRE (written by Tim Berners-Lee), a hypertext program that allowed scientists at the particle physics lab to keep track of people, software, and projects using hypertext (hyperlinks).

1982: The first emoticon

![]()

While many people credit Kevin MacKenzie with the invention of the emoticon in 1979, it was Scott Fahlman in 1982 who proposed using :-) after a joke, rather than the original -) proposed by MacKenzie. The modern emoticon was born.

1983: Arpanet computers switch over to TCP/IP

January 1, 1983 was the deadline for Arpanet computers to switch over to the TCP/IP protocols developed by Vinton Cerf. A few hundred computers were affected by the switch. The name server was also developed in ‘83.

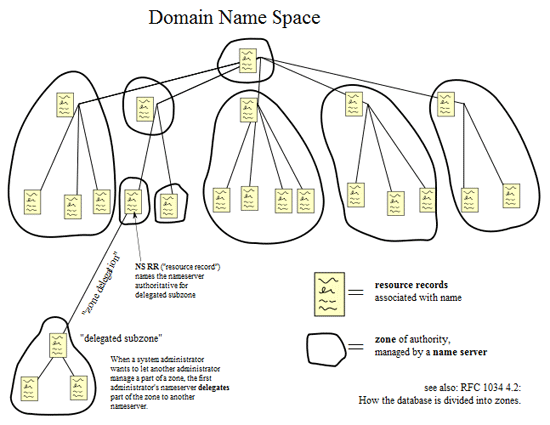

1984: Domain Name System (DNS)

The domain name system was created in 1984 along with the first Domain Name Servers (DNS). The domain name system was important in that it made addresses on the Internet more human-friendly compared to its numerical IP address counterparts. DNS servers allowed Internet users to type in an easy-to-remember domain name and then converted it to the IP address automatically.

1985: Virtual communities

1985 brought the development of The WELL (short for Whole Earth ‘Lectronic Link), one of the oldest virtual communities still in operation. It was developed by Stewart Brand and Larry Brilliant in February of ‘85. It started out as a community of the readers and writers of the Whole Earth Review and was an open but "remarkably literate and uninhibited intellectual gathering". Wired Magazine once called The Well "The most influential online community in the world."

1986: Protocol wars

The so-called Protocol wars began in 1986. European countries at that time were pursuing the Open Systems Interconnection (OSI), while the United States was using the Internet/Arpanet protocol, which eventually won out.

1987: The Internet grows

By 1987, there were nearly 30,000 hosts on the Internet. The original Arpanet protocol had been limited to 1,000 hosts, but the adoption of the TCP/IP standard made larger numbers of hosts possible.

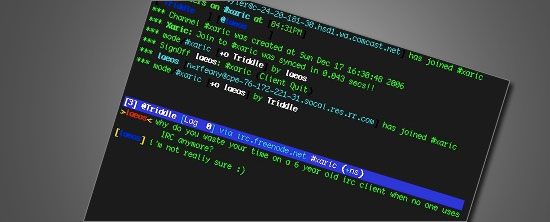

1988: IRC – Internet Relay Chat

Also in 1988, Internet Relay Chat (IRC) was first deployed, paving the way for real-time chat and the instant messaging programs we use today.

1988: First major malicious internet-based attack

One of the first major Internet worms was released in 1988. Referred to as "The Morris Worm", it was written by Robert Tappan Morris and caused major interruptions across large parts of the Internet.

1989: AOL is launched

When Apple pulled out of the AppleLink program in 1989, the project was renamed and America Online was born. AOL, still in existence today, later on made the Internet popular amongst the average internet users.

1989: The proposal for the World Wide Web

1989 also brought about the proposal for the World Wide Web, written by Tim Berners-Lee. It was originally published in the March issue of MacWorld, and then redistributed in May 1990. It was written to persuade CERN that a global hypertext system was in CERN’s best interest. It was originally called "Mesh"; the term "World Wide Web" was coined while Berners-Lee was writing the code in 1990.

1990: First commercial dial-up ISP

1990 also brought about the first commercial dial-up Internet provider, The World. The same year, Arpanet ceased to exist.

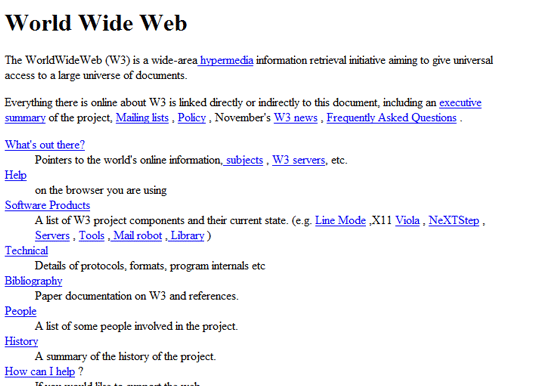

1990: World Wide Web protocols finished

The code for the World Wide Web was written by Tim Berners-Lee, based on his proposal from the year before, along with the standards for HTML, HTTP, and URLs.

1991: First web page created

1991 brought some major innovations to the world of the Internet. The first web page was created and, much like the first email explained what email was, its purpose was to explain what the World Wide Web was.

1991: First content-based search protocol

Also in the same year, the first search protocol that examined file contents instead of just file names was launched, called Gopher.

1991: MP3 becomes a standard

Also, the MP3 file format was accepted as a standard in 1991. MP3 files, being highly compressed, later become a popular file format to share songs and entire albums via the internet.

1991: The first webcam

One of the more interesting developments of this era, though, was the first webcam. It was deployed at a Cambridge University computer lab, and its sole purpose was to monitor a particular coffee maker so that lab users could avoid wasted trips to an empty coffee pot.

1993: Mosaic – first graphical web browser for the general public

The first widely downloaded Internet browser, Mosaic, was released in 1993. While Mosaic wasn’t the first web browser, it is considered the first browser to make the Internet easily accessible to non-techies.

1993: Governments join in on the fun

In 1993, both the White House and the United Nations came online, marking the beginning of the .gov and .org domain names.

1994: Netscape Navigator

Mosaic’s first big competitor, Netscape Navigator, was released the year following (1994).

1995: Commercialization of the internet

1995 is often considered the first year the web became commercialized. While there were commercial enterprises online prior to ‘95, there were a few key developments that happened that year. First, SSL (Secure Sockets Layer) encryption was developed by Netscape, making it safer to conduct financial transactions (like credit card payments) online.

In addition, two major online businesses got their start the same year. The first sale on "Echo Bay" was made that year. Echo Bay later became eBay. Amazon.com also started in 1995, though it didn’t turn a profit for six years, until 2001.

1995: Geocities, the Vatican goes online, and JavaScript

Other major developments that year included the launch of Geocities (which officially closed down on October 26, 2009).

The Vatican also went online for the first time.

Java and JavaScript (originally called LiveScript by its creator, Brendan Eich, and deployed as part of the Netscape Navigator browser – see comments for explanation) was first introduced to the public in 1995. ActiveX was launched by Microsoft the following year.

1996: First web-based (webmail) service

In 1996, HoTMaiL (the capitalized letters are an homage to HTML), the first webmail service, was launched.

1997: The term "weblog" is coined

While the first blogs had been around for a few years in one form or another, 1997 was the first year the term "weblog" was used.

1998: First new story to be broken online instead of traditional media

In 1998, the first major news story to be broken online was the Bill Clinton/Monica Lewinsky scandal (also referred to as "Monicagate" among other nicknames), which was posted on The Drudge Report after Newsweek killed the story.

1998: Google!

Google went live in 1998, revolutionizing the way in which people find information online.

1998: Internet-based file-sharing gets its roots

In 1998 as well, Napster launched, opening up the gates to mainstream file-sharing of audio files over the internet.

1999: SETI@home project

1999 is the year when one of the more interesting projects ever brought online: the SETI@home project, launched. The project has created the equivalent of a giant supercomputer by harnessing the computing power of more than 3 million computers worldwide, using their processors whenever the screensaver comes on, indicating that the computer is idle. The program analyzes radio telescope data to look for signs of extraterrestrial intelligence.

2000: The bubble bursts

2000 was the year of the dotcom collapse, resulting in huge losses for legions of investors. Hundreds of companies closed, some of which had never turned a profit for their investors. The NASDAQ, which listed a large number of tech companies affected by the bubble, peaked at over 5,000, then lost 10% of its value in a single day, and finally hit bottom in October of 2002.

2001: Wikipedia is launched

With the dotcom collapse still going strong, Wikipedia launched in 2001, one of the websites that paved the way for collective web content generation/social media.

2003: VoIP goes mainstream

In 2003: Skype is released to the public, giving a user-friendly interface to Voice over IP calling.

2003: MySpace becomes the most popular social network

Also in 2003, MySpace opens up its doors. It later grew to be the most popular social network at one time (thought it has since been overtaken by Facebook).

2003: CAN-SPAM Act puts a lid on unsolicited emails

Another major advance in 2003 was the signing of the Controlling the Assault of Non-Solicited Pornography and Marketing Act of 2003, better known as the CAN-SPAM Act.

2004: Web 2.0

Though coined in 1999 by Darcy DiNucci, the term "Web 2.0", referring to websites and Rich Internet Applications (RIA) that are highly interactive and user-driven became popular around 2004. During the first Web 2.0 conference, John Batelle and Tim O’Reilly described the concept of "the Web as a Platform": software applications built to take advantage of internet connectivity, moving away from the desktop (which has downsides such as operating system dependency and lack of interoperability).

2004: Social Media and Digg

The term "social media", believed to be first used by Chris Sharpley, was coined in the same year that "Web 2.0" became a mainstream concept. Social media–sites and web applications that allow its users to create and share content and to connect with one another–started around this period.

Digg, a social news site, launched on November of 2004, paving the way for sites such as Reddit, Mixx, and Yahoo! Buzz. Digg revolutionized traditional means of generating and finding web content, democratically promoting news and web links that are reviewed and voted on by a community.

2004: "The" Facebook open to college students

Facebook launched in 2004, though at the time it was only open to college students and was called "The Facebook"; later on, "The" was dropped from the name, though the URL http://www.thefacebook.com still works.

2005: YouTube – streaming video for the masses

YouTube launched in 2005, bringing free online video hosting and sharing to the masses.

2006: Twitter gets twittering

Twitter launched in 2006. It was originally going to be called twittr (inspired by Flickr); the first Twitter message was "just setting up my twttr".

2007: Major move to place TV shows online

Hulu was first launched in 2007, a joint venture between ABC, NBC, and Fox to make popular TV shows available to watch online.

2007: The iPhone and the Mobile Web

The biggest innovation of 2007 was almost certainly the iPhone, which was almost wholly responsible for renewed interest in mobile web applications and design.

2008: "Internet Election"

The first "Internet election" took place in 2008 with the U.S. Presidential election. It was the first year that national candidates took full advantage of all the Internet had to offer. Hillary Clinton jumped on board early with YouTube campaign videos. Virtually every candidate had a Facebook page or a Twitter feed, or both.

Ron Paul set a new fundraising record by raising $4.3 million in a single day through online donations, and then beat his own record only weeks later by raising $4.4 million in a single day.

The 2008 elections placed the Internet squarely at the forefront of politics and campaigning, a trend that is unlikely to change any time in the near future.

2009: ICANN policy changes

2009 brought about one of the biggest changes to come to the Internet in a long time when the U.S. relaxed its control over ICANN, the official naming body of the Internet (they’re the organization in charge of registering domain names).

The Future?

Where is the future of the Internet headed? Share your opinions in the comments section.

Sources

sábado, 14 de noviembre de 2009

“INTERGRUPO SE FOCALIZA EN LAS SOLUCIONES DE MICROSOFT”

El ejecutivo revela que para el 2010 InterGrupo estima alcanzar un nivel de ventas de US$10 millones en el mercado nacional.

En nuestro país, la empresa se enfoca comercialmente en la tecnología Microsoft a través de sus unidades de Licenciamiento, Infraestructura e Ingeniería de Software.

(americasistemas.com.pe. Lima, Perú – 11/11/2009) Con apenas seis meses de operaciones en nuestro país, InterGrupo, compañía regional proveedora de soluciones tecnológicas de primer nivel, se ha trazado la meta de facturar US$10 millones para el próximo año en el mercado peruano.

(americasistemas.com.pe. Lima, Perú – 11/11/2009) Con apenas seis meses de operaciones en nuestro país, InterGrupo, compañía regional proveedora de soluciones tecnológicas de primer nivel, se ha trazado la meta de facturar US$10 millones para el próximo año en el mercado peruano.

Asimismo, a fines del 2010, la oficina local de InterGrupo espera contar con cerca de 100 personas entre profesionales y técnicos de primer nivel. Estos anuncios son parte de los objetivos inmediatos planteados por el Gerente General de InterGrupo para el Perú, Carlos Prado.

En diálogo con América Sistemas, el ejecutivo manifestó que su representada destaca en el mercado por su alto nivel de especialización y experiencia sobre la tecnología de Microsoft. “Eso nos hace diferentes. En tal sentido, nos proyectamos en ser el partner de Microsoft número uno en ventas porque somos la mejor opción costo-beneficio para nuestros clientes que pertenecen a distintos segmentos de la industria”, acotó.

OFERTA EN GESTIÓN DE ACTIVOS DE SOFTWARE

Las unidades de negocio que InterGrupo desarrolla en nuestro país son: Licenciamiento, Infraestructura e Ingeniería de Software.

“La unidad de Licenciamiento está enfocada 100% a la tecnología de Microsoft. InterGrupo es Gold Certified Partner de este fabricante y cuenta con la categoría LAR (Large Account Reseller), que nos permite ofrecer licencias por volumen de acuerdo a los requerimientos de los clientes. Además, estamos innovando en el mercado al ofrecer Software Asset Management (SAM)”, dijo el entrevistado.

SAM (Gestión de Activos de Software, en español) es una metodología y un conjunto de procesos que le permitirán gestionar a las empresas sus licencias y elementos de software, reducir costos y mejorar la fiabilidad y seguridad de sus sistemas de TI.

La unidad de Infraestructura está integrada por ingenieros certificados por Microsoft y con experiencia en proyectos de gran tamaño.

Por su parte, la unidad de Ingeniería de Software ofrece una amplia variedad de servicios de consultoría y desarrollo de software Microsoft y de otras tecnologías (Java, .NET, Cobol, etc.). “Nuestra fábrica de software es la única en nuestro país que tiene la certificación CMMI nivel 4, el más exigente estándar de la industria”, enfatizó el gerente de InterGrupo.

PARTNER DESTACADO DE MICROSOFT

Cabe señalar que InterGrupo cuenta con 15 certificaciones Gold de Microsoft, excluyendo el licenciamiento OEM, siendo el único partner LAR peruano del fabricante de software que tiene dicho número de certificaciones y, a su vez, de especializaciones (25 en total).

Cabe señalar que InterGrupo cuenta con 15 certificaciones Gold de Microsoft, excluyendo el licenciamiento OEM, siendo el único partner LAR peruano del fabricante de software que tiene dicho número de certificaciones y, a su vez, de especializaciones (25 en total).

“De esta manera, demostramos que InterGrupo se focaliza en las soluciones de Microsoft. Por eso, hacemos las estrategias más innovadoras del mercado”, expresó Carlos Prado.

Actualmente, los procesos de la compañía están certificados en ISO 9000 e ISO 20000. Además, InterGrupo es socio de Pink Elephant para ITIL.

Prado afirmó que InterGrupo tiene oficinas propias en Colombia, Estados Unidos, España, Ecuador, Perú y República Dominicana. “El próximo año nos estableceremos en Brasil”, reveló.

Entre los clientes locales de InterGrupo destacan Topitop, Bonus, Compañía Minera Casapalca, Amcor, Corporación Radial del Perú, Coltur Perú, PROSAC, Paz Centenario, Universidad Antonio Ruiz de Montoya, entre otros.

Por otro lado, cabe destacar que InterGrupo está organizando el seminario denominado “Optimice la administración de sus activos de Software – SOM” a realizarse este 17 de noviembre. El expositor del evento será el Consultor en Gestión de Activos de Software, Juan David Barbosa.

Este año será probablemente el primero en el que la industria de cómputo en el Perú, no experimentará crecimiento.

Este año será probablemente el primero en el que la industria de cómputo en el Perú, no experimentará crecimiento. En este mismo período, en término de dólares, el hardware fue “el driver” que lideró el crecimiento de la industria. Tal como lo revelan nuestras cifras proyectadas hasta fin de año tomando como base los resultados acumulados a Setiembre 2009, debemos esperar un decrecimiento entre 4 y 6 puntos con respecto al año anterior (2008), en términos de la inversión en dólares que realicen los usuarios empresariales y de hogares en hardware. La buena noticia es que las categorías de software y servicios presentarían crecimientos positivos pero pequeños, probablemente alrededor de un dígito. Sin embargo como el volumen de la industria, tal como lo mencionamos lo lleva el hardware, y ésta categoría decrecerá, las otras dos no podrán compensar los resultados del período. Si en este último trimestre no cambia la demanda es muy posible que los resultados del año en la industria muestren un decrecimiento alrededor del 2% en el total de la inversión en el país en la industria de cómputo. Según nuestras cifras a Setiembre, dentro de la categoría de hardware, los productos que menos se han vendido, son las computadoras de escritorio, impresoras, partes y piezas para el ensamblaje de computadoras y los servidores entre otros. Los productos que mejor se han defendido son las memorias flash, networking y algunos accesorios para computadoras. Otra buena noticia es que las portátiles han continuado con su crecimiento este año aún excluyamos las OLPC traídas por el gobierno. Nuestra opinión sobre esta situación, es que como producto de la crisis, las empresas usuarias y el gobierno suspendieron las inversiones en adquisición de infraestructura TI. Por otro lado en el frente de proveedores, como muchas empresas son trasnacionales y fueron impactadas directamente por la crisis norteamericana, se tomaron decisiones de recortar a nivel mundial los presupuestos de marketing, dejando huérfanos de recursos, en nuestro país a de sus subsidiarias en desmedro de sus resultados. A esto se suma la caída de precios para asegurar la rotación de los stocks y la caída natural de los precios de la industria. Mantenemos aun la esperanza de que en el último trimestre cambien las expectativas, aumente la demanda, y mejore el marketing de la oferta para que los resultados a diciembre cambien. Fernando Grados, Analista Senior |

Presentan lista de los mejores programas antivirus

El laboratorio independiente de ensayos de software, AV Comparatives ha realizado un exhaustivo estudio comparativo de 16 programas antivirus para el mercado de consumidores.

El laboratorio independiente de ensayos de software, AV Comparatives ha realizado un exhaustivo estudio comparativo de 16 programas antivirus para el mercado de consumidores. Los resultados están disponibles en un informe de 27 paginas publicado en el sitio de la organización.

Los programas incluidos en la comparativa fueron los siguientes:

- Avast Professional Edition 4.8

- AVG Anti-Virus 8.5

- AVIRA AntiVir Premium 9.0

- BitDefender Anti-Virus 2010

- eScan Anti-Virus 10.0

- ESET NOD32 Antivirus 4.0

- F-Secure AntiVirus 2010

- G DATA AntiVirus 2010

- Kaspersky Anti-Virus 2010

- Kingsoft AntiVirus 9

- McAfee VirusScan Plus 2009

- Microsoft Security Essentials 1.0

- Norman Antivirus & Anti-Spyware 7.10

- Sophos Anti-Virus 7.6

- Symantec Norton Anti-Virus 2010

- Trustport Antivirus 2009.

El estudio se concentró en la capacidad de los programas de eliminar virus de los PC infectados, y no solo detectarlos. Aparte de ello se buscó establecer en qué medida el proceso de limpieza elimina todos los vestigios del virus, o si éste deja residuos del daño causado al sistema.

Los resultados son presentados en la tabla siguiente:

Removal of malware/leftovers: remoción de malware/residuos

Good/average/poor: bueno/promedio/deficiente

eScan, Symantec y Microsoft Security Essentials fueron los únicos programas en conseguir la clasificación "bueno" tanto en la eliminación del virus como de sus vestigios. Por ejemplo, un gran número de programas antivirus no lograron eliminar elementos dejados por los virus en el registro de Windows.

Los únicos programas en conseguir 3 estrellas fueron eScan, Symantec y Microsoft. Entre ellos, Microsoft Security Essentials es el único de los tres distribuidos gratuitamente.

El informe completo está disponible en ésta página (documento PDF).

Microsoft presentará versión móvil de Office 2010

[ 04/11/2009 - 11:18 CET ]

[ 04/11/2009 - 11:18 CET ] Microsoft anuncia para la conferencia Tech-Ed, a realizarse la próxima semana en Berlín, una presentación completa de la versión móvil de Office 2010, y el potencial que representa para diversas tecnologías y escenarios.

Diario Ti: Hasta ahora, Microsoft se ha referido frecuentemente a Office 2010 - en sus versiones para escritorio y web - aunque no ha profundizado el tema de la versión móvil del paquete ofimático. Esta situación cambiará durante la próxima semana, cuando el representante de Microsoft, Dev Balasubramanian, se refiera al tema en una conferencia titulada "OFS01-IS Microsoft Office Mobile 2010 in Depth".

Entre otras cosas, se referirá a las aplicaciones que Office Mobile, que en su versión actual incluyen Word, Excel, Powerpoint y OneNote, como asimismo diversas áreas de cooperación con software de terceros, flujo de trabajo móvil, y acceso móvil a datos, personas y recursos corporativos.

Aparte de ello, Balasubramanian se referirá a la aplicación Sharepoint Workspace Mobile, en versión rediseñada, y a la infraestructura necesaria para soportarla.

Se espera que la versión 2010 de Office Mobile sea especialmente adaptada a Windows Mobile 7, cuyo lanzamiento está previsto para fines de 2010.

Anteriormente este año, Microsoft ha publicado un breve vídeo donde Balasubramanian esboza algunas de las novedades de Office Mobile 2010. El vídeo está disponible en ésta página

See What´s New in Microsoft Office Mobile 2010

Nuevas aplicaciones realzan el atractivo de Windows 7

Programas gratuitos disponibles en Internet agregan

Programas gratuitos disponibles en Internet agreganfuncionalidad y atractivo al nuevo sistema operativo de

Microsoft.

Windows 7 ha sido bien recibido a niveles empresarial y

particular. Paralelamente, desarrolladores de todo el mundo

presentan constantemente aplicaciones de mayor o menor

interés, especialmente diseñadas para Windows 7.

El blog Lifehacker ha elaborado una lista de 10 aplicaciones y

extensiones para Windows 7, que incrementan su

funcionalidad o realzan su elegancia.

Por ejemplo, una aplicación permite instalar un icono de

Gmail en la barra de tareas, proporcionando acceso a las

funciones más usadas del servicio de correo de Google.

Winfox, por su parte, incrementa la funcionalidad de Firefox,

también en la barra de tareas, auque por ahora no cuenta

con el soporte oficial de Mozilla.

Lifehacker incluye en su lista un programa que incrementa la

funcionalidad de alt+tab, permitiendo al usuario apilar

carpetas en la barra de tareas o instalar una serie de

programas automáticamente.

La lista completa está

disponible en el sitio de Lifehacker.

Google ofrece ahora hasta 16 terabytes de espacio a usuarios

Actualmente, todos los usuarios de Google Mail y Picasa Webalbun obtienen 7,3 GB de espacio gratuito para almacenar su correo electrónico y fotografías. Aunque tal volumen debería cubrir las necesidades de espacio de la mayoría de los usuarios, Google ofrece ahora la posibilidad de comprar más espacio en disco.

Actualmente, todos los usuarios de Google Mail y Picasa Webalbun obtienen 7,3 GB de espacio gratuito para almacenar su correo electrónico y fotografías. Aunque tal volumen debería cubrir las necesidades de espacio de la mayoría de los usuarios, Google ofrece ahora la posibilidad de comprar más espacio en disco. Google ha presentado un nuevo modelo de precios para espacio de almacenamiento, que aumenta en 40 veces la capacidad máxima que puede ser alquilada.

Anteriormente era posible comprar 10 GB extra por 20 dólares anuales, siendo posible alquilar hasta 400 GB.

La nueva estructura de precios está disponible mediante Google Mail (configuración > cuentas importación, añadir espacio de almacenamiento adicional).

Los precios comienzan en 5 dólares para 20 GB extra de espacio. Por 20 dólares el usuario obtiene 80 GB de espacio y por 50 dólares 200 GB. La tarifa para 400 GB es de 100 dólares y por 256 dólares se obtiene 1 TB de espacio ("suficiente para almacenar 512.000 fotos de una cámara de 5 MP", según escribe Google).

Las categorías siguientes son de 2 TB, 4 TB, 8 TB y 16 TB, con tarifas de 512, 1024, 2048 y 4096 dólares anuales, respectivamente.

Intel Reader transforma textos en palabras

Intel Reader es un dispositivo móvil de mano para personas con discapacidades relacionadas con la lectura, tales como la dislexia, la visión limitada o la ceguera.

Intel Reader es un dispositivo móvil de mano para personas con discapacidades relacionadas con la lectura, tales como la dislexia, la visión limitada o la ceguera. Intel Corporation anunció Intel Reader, dispositivo de mano móvil diseñado para aumentar la independencia de las personas que tienen problemas de lectura de texto impreso estándar.

Intel Reader, del tamaño de un libro de bolsillo, convierte el texto impreso en texto digital y luego se lo lee en voz alta al usuario. Su diseño combina una cámara de alta resolución con el poder de un procesador Intel Atom, lo que le permite a los usuarios apuntar al texto impreso, captarlo y escucharlo.

Cuando Intel Reader se utiliza junto con la solución Intel Portable Capture Station, pueden capturarse grandes cantidades de texto, como un capítulo o un libro entero, para su posterior lectura. Los usuarios tendrán un acceso cómodo y flexible a una gran variedad de materiales impresos, lo que ayudará a aumentar no sólo su libertad sino también a mejorar su productividad y su eficiencia en los estudios, el trabajo y el hogar.

Intel Reader ha sido aprobado por la International Dyslexia Association como un importante avance en la tecnología asistencial. También se encuentra trabajando con la Association of Assistive Technology Act Programs, el Council for Exceptional Children, Lighthouse International, el National Center for Learning Disabilities y la National Federation of the Blind, para ayudar a alcanzar y atender las necesidades de las personas que tienen dificultad para leer textos impresos.

“Estamos orgullosos de ofrecer el Intel Reader como una herramienta para personas que tienen problemas de lectura de textos impresos estándar, para que puedan acceder más fácilmente a la información que muchos de nosotros consideramos cotidiana, como la lectura de una carta de oferta de trabajo o incluso el menú de una restaurante", dijo Louis Burns, vicepresidente y gerente general del Digital Health Group de Intel.

Fuente: Intel Corporation.

Anuncian seminario online gratuito Microsoft Dynamics NAV 2009

Aitana crea el ciclo de seminarios Aitana Online, unas sesiones sobre novedades del sector TIC que se realizarán en Internet de manera gratuita.

Aitana crea el ciclo de seminarios Aitana Online, unas sesiones sobre novedades del sector TIC que se realizarán en Internet de manera gratuita. Están dirigidos a Directores Generales y Gerentes, así como Directores de Sistemas, Informática, TIC y Finanzas.

El próximo martes 17 de noviembre, de 12.00h a 13.00h, tendrá lugar el seminario online Microsoft Dynamics NAV 2009 - Un ERP que comprende al usuario, que contará con la intervención de Microsoft.

Microsoft Dynamics NAV 2009, y su Service Pack 1, confirman el compromiso de Microsoft de hacer de Microsoft Dynamics una verdadera herramienta de productividad pensada para las personas, fácil de usar, realmente potente y muy flexible.

Los usuarios de Microsoft Dynamics NAV, tendrán en esta sesión una excelente oportunidad para conocer las novedades de esta solución y evaluar el interés de migrar a esta nueva versión. Y para aquellos que aún no conocen Microsoft Dynamics, ésta es una gran oportunidad para saber por qué la mayoría de analistas del mercado aseguran que Microsoft Dynamics supone una nueva generación de ERP´s.

Seminario dirigido tanto a Compañías usuarias de Microsoft Dynamics NAV como a Compañías interesadas en conocer esta solución.

Fuente: Aitana

Links

- Apple Safari for Windows 4.0.4

El navegador Safari de Apple para Windows recibe una nueva actualización. - Real Temp 3.40

Un programa gratuito de monitorización de temperaturas que incluso tiene plugin para Rivatuner y que funciona para todos los procesadores Intel recibe una nueva y gran actualización. - MDaemon 10.1.2

Un servidor de correo profesional y de pago que recibe una nueva actualización, probablemente interesante para administradores de red o de dominios.  MSI AfterBurner 1.40

MSI AfterBurner 1.40

Herramienta de overclock para las tarjetas gráficas de MSI, por lo menos las que soporten este programa. Vemos como la versión 1.4.0 añade soporte inicial para las futuras HD 5970, además de muchas correcciones y mejoras.- Maxthon 2.5.10.2994

Nueva versión de este navegador basado en el motor de IE. - Yahoo! Messenger 10.0.0.1102

Nueva versión del cliente de mensajería instantánea de Yahoo!.

Los robots que invadieron Uruguay

Ya hemos visto antes que un cortometraje, bien llevado, puede tener el nivel de ciertas superproducciones de Hollywood. El ejemplo de hoy es un claro indicativo de ello.

Realizado por Federico Álvarez (MURDOC Films), este corto, llamado "AtaqueDePánico", contó con un gasto de unos 300 dólares y 6 meses de trabajo de su creador. Para dirigir y animar en 3D, Álvarez tuvo la ayuda del servicio de pos-producción "Aparato", y del uso de herramientas como 3D Max, FumeFx, Glu3D y Boujou.

El corto básicamente nos muestra una invasión de robots poco amigables, que se pasean por Montevideo (Uruguay), destruyendo puntos emblemáticos como la Torre de Antel, el Palacio Legislativo, el Salvo o la Intendencia. Sin más, os dejamos con el vídeo:

¿Qué les pasa a tus células sanguíneas cuando usas un móvil?

En DarkVision Hardware han encontrado un interesante vídeo que dice mostrar los efectos del uso del teléfono móvil en las células de la sangre. Antes de tomar la primera muestra y ponerla bajo un microscopio HC-4000 live ("en vivo") el sujeto de la prueba había estado sin usar un móvil durante 24 horas. Posteriormente va mostrando las reacciones celulares con muestras tras 6, 17 y 29 minutos de llamada ininterrumpida sin utilizar auriculares. Según el vídeo, tras 17 minutos de llamada la sangre puede compararse a la de una persona que sufra de una fiebre gripal severa.

Otro dato a destacar es la aceleración del envejecimiento celular. Tras 30 minutos de uso las células se desmoronan, son incapaces de mover el oxígeno y de unirse a otras células. No es un estudio científico en toda regla y quizá parezca algo exagerado, pero da que pensar.

Blockbuster alquila películas en tarjetas SD

El gigante Blockbuster va a comenzar el alquiler de películas en formato SD.

¿Y cómo lo harán? Pues mediante unas máquinas de auto servicio. Se van a presentar en más de 30 países, y funcionarán de la siguiente manera: llevaremos nuestra tarjeta SD, seleccionaremos la película y la máquina hará una copia en nuestra unidad. Y listo.

Por cierto, que no habrá que devolverla, porque obviamente contará con un espléndido DRM que inutilizará el vídeo pasado un tiempo (sólo el vídeo).

El precio del alquiler será de 1,99 dólares, y se dispondrán de 30 días para su visionado completo, aunque si has comenzado a ver el filme, sólo tendremos 2 días para completarlo. Revolucionario o no, el caso es que ya contamos con nuevo sistema de alquiler. ¿Lo veremos por estos lares?

Snegenes P, consola retro portátil

Un modder llamado Trstn18 ha creado una consola portátil que puede reproducir juegos de las clásicas Super Nintendo, NES y Megadrive. El resultado es la Snegenes P.

Se ha realizado implementado el hardware de una Snes Mini y de la GEN X, que era una clónica de Megadrive y NES. Con 6 baterías 2.600 mAh se pueden jugar entre 5 y 7 horas (dependiendo del sistema que se use). Las dimensiones del bicho son: 21,8 centímetros de largo, 13,7 de alto y 2,54 de grosor. Así que de portátil, quizá no mucho...

Visita a la Fab 1 de CPUs de AMD (GF) en Dresden

El mundo de la informática es harto complicado y las cosas nos fallan cuándo uno menos se lo espera, sin embargo se trata de componentes técnicamente muy complejos y que requieren unas instalaciones impresionantes para ser fabricados con una tasa de errores aceptable, puesto que bajo unas condiciones normales este trabajo de precisión sería imposible de llevar a cabo y no veríamos ni un chip funcional.

Parece que el pasado 11 de noviembre Globalfoundries organizó una visita para la prensa a sus instalaciones de la Fab 1, antiguamente de AMD, donde entre otras cosas de fabrican procesadores para AMD.

Uno de los periodistas era de PC Games Hardware, y a través de interesantes imágenes podemos hacernos una idea de lo que hay dentro de una de estas fábricas de alta tecnología donde se fabrican procesadores y visitar lo que llaman una "Cleanroom". O habitación limpia para impedir que se cuelen elementos extraños que puedan perjudicar al proceso de fabricación

Debajo de cada foto (37) nos explican algunos detalles interesantes de la visita. Lectura visual recomendada.

OpenSUSE 11.2 ya disponible

Ya está lista para descarga una de las distribuciones de Linux más conocidas y apreciadas por la comunidad: OpenSUSE, que llega a su versión 11.2 con bastantes novedades.

Incorpora el Kernel 2.6.31 para una mayor estabilidad y velocidad del sistema. Hace la instalación con el sistema de archivos Ext4 por defecto, aunque es compatible con versiones anteriores (Ext3). No ha incorporado Grub en su última versión, dejando la antigua (al contrario que Ubuntu). Por defecto, el entorno de escritorio es KDE, si bien da la opción de instalar Gnome o XFCE.

Se pueden descargar multitud de versiones, ya sea un DVD con todas las opciones y software disponibles, un entorno Gnome que además es LiveCD, o uno KDE también LiveCD. Las opciones de descarga están disponibles aquí.

Dirt 2 para el 3 de diciembre, requisitos mínimos

Dirt 2 es un juego del que ya se ha hablado mucho y, aparte de pertenecer a una saga muy conocida, el motivo principal de desviar tanta atención es que el juego se anunció a bombo y platillo con soporte para DirectX 11 y muchas tarjetas gráficas ATi Radeon HD 5870 se han vendido con el cupón para su descarga cuando llegue al mercado el próximo día 3 de diciembre.

Será el tercer juego que salga al mercado que aprovechará algunas características de DirectX 11, los primeros son BattleForge y STALKER: Call of Pripyat, aunque este segundo aún no está comercializado fuera de Rúsia y Alemania. Hoy han salido a la luz los requisitos mínimos y recomendados, estos últimos son de los más elevados y elitistas que hemos visto en los últimos tiempos. Aunque evidentemente sabremos esto con más certeza a partir del día que salga al mercado y lluevan análisis.

Requisitos mínimos:

- S.O.: Microsoft Windows XP, Vista o Windows 7

- CPU: Intel Pentium 4 3.0 GHz o AMD Athlon 64 3400+

- Memoria: 1GB (2GB para Windows Vista/7)

- Disco duro: 10GB

- VGA: ATI Radeon X1500 o NVIDIA GeForce 6800

Requisitos recomendados:

- S.O.: Microsoft Windows Vista o Windows 7

- CPU: Intel Core i7 o AMD Phenom II

- Memoria: 3GB

- Disco duro: 10GB

- VGA: ATI Radeon HD 5700 o superior

Google Caffeine llega a los data center

El nuevo motor de búsqueda de Google, Caffeine, ya ha finalizado su fase de pruebas, y está preparado para implementarse en los centros de datos de la compañía.

Esto actualizará la arquitectura de búsquedas de Google, aunque es muy posible que, como afirman los responsables, los usuarios finales apenas noten diferencias respecto al buscador actual.

Gracias a este cambio, se ha conseguido que el buscador sea más flexible, rápido y potente, logrando que la indexación sea aún más veloz si cabe. Tras un período de pruebas y una buena respuesta por parte de los usuarios, finalmente la compañía lo lanza oficialmente. Veremos si hay cambios sustanciales.

Nueva laptop Acer Aspire 5536

Acer presenta al mercado peruano su nueva laptop Aspire 5536, la cual ha sido diseñada pensando en aquellos usuarios amantes del entretenimiento multimedia.

aquellos usuarios amantes del entretenimiento multimedia.

Incorpora el procesador AMD Athlon 64 X2 Dual Core QL-64 2,1Ghz, permitiéndole al usuario jugar y/o trabajar múltiples programas, de forma simultánea, sin saturaciones ni esperas. Además, la selección de soluciones gráficas HD (Alta definición) que tiene la nueva Aspire 5536, garantiza imágenes de alta calidad.

El rendimiento y productividad quedan garantizados con la Aspire 5536 de ACER, pues ésta posee una memoria RAM de 3 GB DDR2, expandible hasta 8 GB; y un disco duro de 250 GB, para que el usuario pueda ejecutar aplicaciones exigentes, además de guardar y compartir sus archivos de manera óptima y segura.

La Aspire 5536 está equipada con una pantalla LCD TFT Acer CineCrystal™ HD de alto brillo de 15,6” para disfrutar de una vista cinemática real, con imágenes realistas y una relación de contraste superior. Para que puedas disfrutar de un entretenimiento completo, este nuevo modelo de ACER incorpora la 3ª generación de Dolby Home Theater y una unidad de doble capa DVD-Súper Multi para videos, música e imágenes de alta definición.

Con la nueva Aspire 5536 de ACER, también podrás gozar de conectividad al máximo: la conexión de red Acer InviLink™ Nplify™ 802.11b/g/Draft-N Wi-Fi te permitirá navegar en Internet de forma estable, rápida y sencilla. La cámara Web y micrófono integrados te facilitarán la realización de video conferencias y participación en el chat con tus amigos.

Otra de las prestaciones que ofrece la Aspire 5536, es el multilector de tarjetas 6 en 1 y 4 puertos USB para acceder a tus fotos, películas, archivos, música, entre otros.

“La nueva Aspire 5536 de ACER es el compañero ideal para aquellos amantes del multimedia móvil eficaz y espectacular”, precisó Vicky Ponce, Gerente Regional de Ventas para Latinoamérica de Acer.

Especificaciones técnicas:

• Procesador AMD Athlon 64 X2 Dual Core QL-64 2,1 Ghz• Memoria de 3 GB DDR2 (expandible a 8 GB)

• Disco Duro de 250 GB

• Grabador de DVD Súper Multi

• Internet Wireless 802.11 b/g Draft- N

• 4 Puertos USB

• Multilector de tarjetas 6 en 1

• Web Cam integrada

• Windows Vista Home Premium

Disponibilidad y Precio:

Disponible en Tiendas Wong, Metro y Oeschle. Precio S/. 2,499